Le défi énergétique de l'alimentation des puces de l'IA

L'intelligence artificielle a décuplé non seulement le traitement de l'information, mais aussi la consommation d'énergie et la production de chaleur. Pour absorber les volumes croissants de données et ne pas entrer en surchauffe, les centres de données vont devoir subir des adaptations majeures. Ces travaux de modernisation vont constituer, pour les entreprises qui fournissent des équipements à haut rendement énergétique et des systèmes de gestion de l'énergie, un moteur de croissance ainsi qu'une source de revenus à l'abri de la menace d'une récession.

Résumé

- Les puces qui alimentent l'IA chauffent beaucoup et sont gourmandes en énergie

- Les centres de données actuels sont mal équipés et ont besoin d'être rénovés

- Ces rénovations vont être favorables aux stratégies axées sur l'énergie intelligente

Le rythme auquel les logiciels d'intelligence artificielle (IA) sont adoptés par les utilisateurs est l'un des plus rapides que les marchés aient jamais connus. Les grands modèles de langage (LLM), qu'utilisent ChatGPT et d'autres bots du même type pour générer des conversations semblables à celles des humains, ne sont que l'une des nombreuses nouvelles applications d'IA qui s'appuient sur le « calcul parallèle », un terme qui désigne le volume colossal de calculs effectués de façon simultanée par des réseaux de puces.

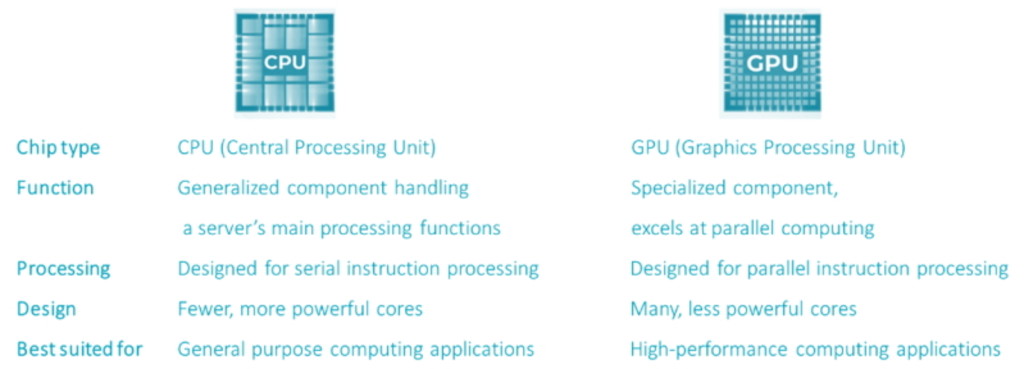

Au cœur de l'infrastructure de l'IA se trouvent les GPU (processeurs graphiques) qui excellent dans le type de calculs parallèles que nécessite l'IA, à savoir des calculs spécialisés et de haute performance. Toute cette puissance de traitement entraîne une consommation d'énergie plus élevée et génère donc plus de chaleur qu'une unité centrale (CPU) équivalente équipant un PC. Voir figure 1.

Figure 1 - Comparaison entre CPU et GPU

Source : GPU vs. CPU - Différence entre les unités de traitement - AWS (amazon.com)

Les GPU haut de gamme sont environ quatre fois plus gourmands en énergie que les CPU. Voilà qui soulève des problèmes de taille pour les centres de données, car l'alimentation électrique calculée à l'origine ne représente plus que 25 % de ce qui est nécessaire pour faire fonctionner les centres de données modernes servant à l'IA. Même les centres de données hyperscale à la pointe de la technologie utilisés par Amazon, Microsoft et Alphabet pour l'informatique basée sur le cloud sont encore alimentés par des CPU. À titre d'exemple, la puce IA A100 que propose actuellement Nvidia a une consommation unitaire constante d'environ 400 W, alors sa dernière puce, la H100, consomme pratiquement le double, soit 700 W, l'équivalent d'un four à micro-ondes. Si un centre de données hyperscale complet, qui abrite en moyenne un million de serveurs, remplaçait chacun de ses serveurs équipé d'une CPU par des serveurs à GPU, l'électricité nécessaire serait multipliée par 4 ou 5 (1 500 MW), soit l'équivalent d'une centrale nucléaire !

Les GPU sont environ quatre fois plus gourmands en énergie que les CPU

Ouvrez votre portefeuille à la puissance des thèmes

Depuis plus de 25 ans, Robeco est à la pointe des stratégies thématiques.

En raison de leur densité de puissance supérieure, ces puces génèrent beaucoup plus de chaleur. Par conséquent, il faut également s'équiper de systèmes de refroidissement plus puissants. Pour réaliser des changements d'une telle ampleur en matière de puissance et de refroidissement, il va falloir repenser entièrement la conception des centres de données pilotés par l'IA. Il en résulte un déséquilibre énorme entre l'offre et la demande, qu'il s'agisse des puces ou de l'infrastructure des centres de données. Compte tenu du temps nécessaire à la construction des centres de données, les experts du secteur sont d'avis que nous sommes au tout début d'une décennie de modernisation de ces centres afin de les rendre plus intelligents.

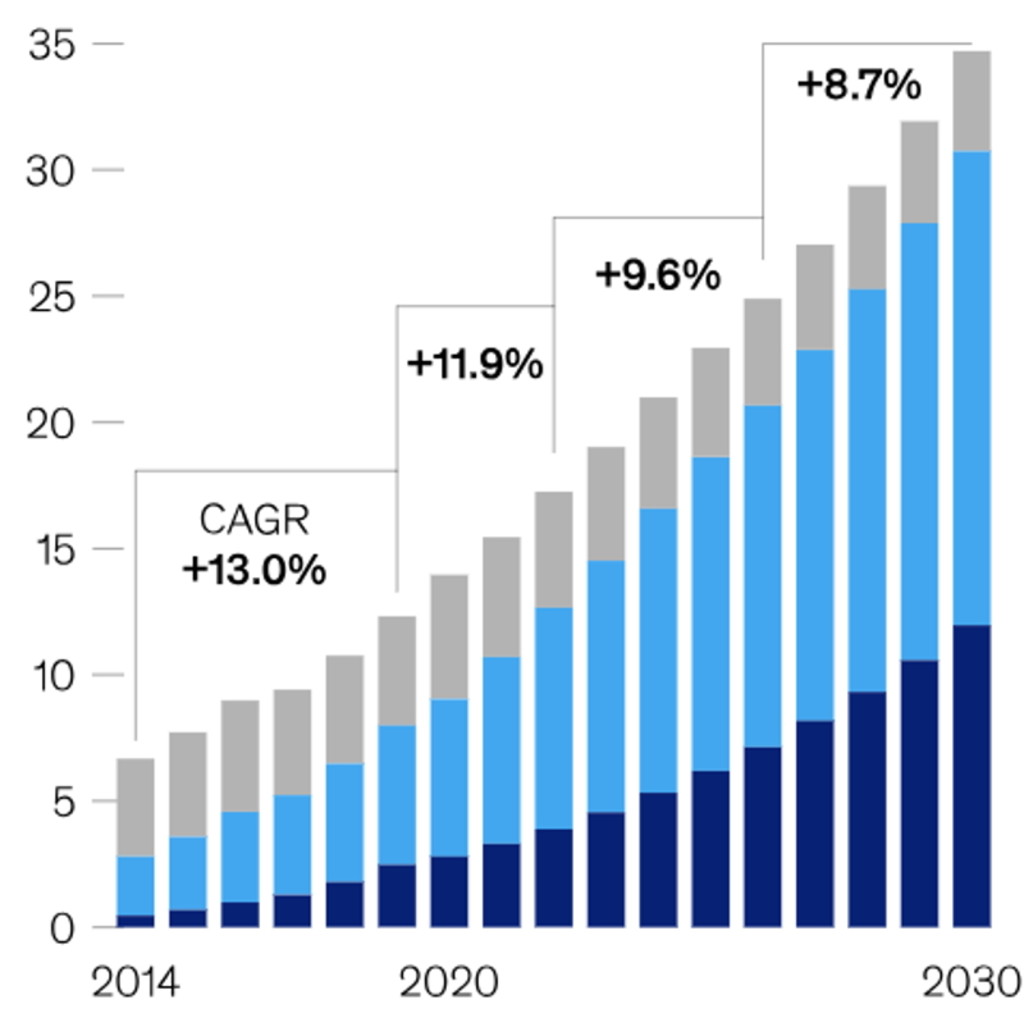

Figure 2 - Hausse de la consommation électrique des centres de données américains (en gigawatts)

Consommation d'énergie pour le stockage, les serveurs et les réseaux incluse. En gris, la consommation d'énergie des centres de données appartenant à des entreprises avec, en bleu clair, la part des entreprises de « colocation » qui louent un espace ou qui gèrent des centres de données pour le compte d'autres entreprises, en bleu foncé, les centres de données hyperscale.

Source : McKinsey & Company, « Investing in the rising data center economy », 2023.

Remaniement total : équiper les centres de données pour répondre aux besoins de l'IA

Des changements structurels de cette ampleur vont exiger des opérations massives de modernisation, non seulement des puces et des serveurs, mais aussi de l'infrastructure électrique qui leur fournit l'énergie nécessaire à leur fonctionnement.

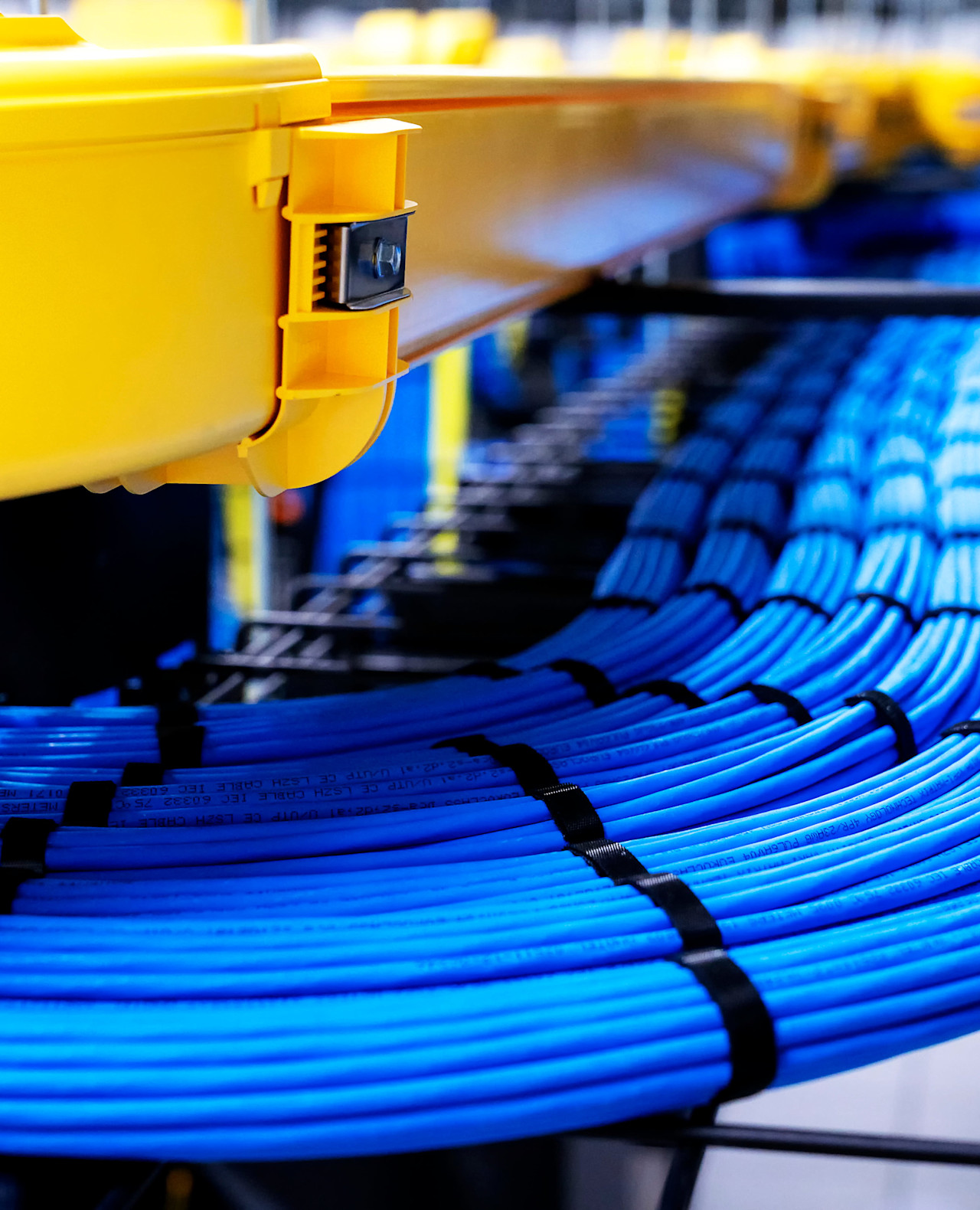

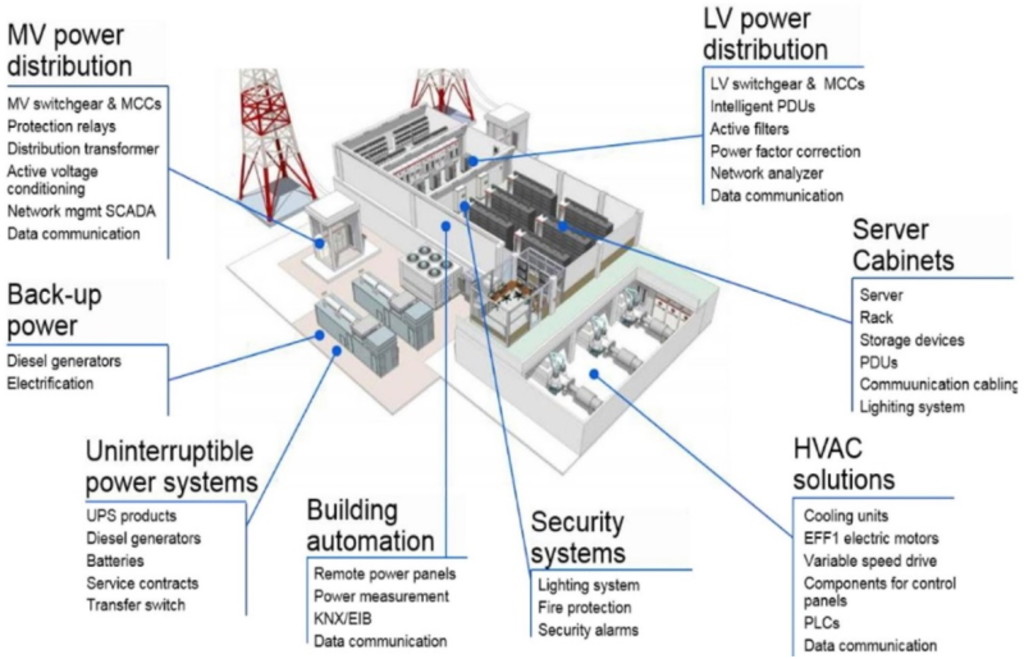

D'après les lois de la physique, une augmentation de l'alimentation électrique se traduit par une augmentation de la tension électrique et/ou du courant (puissance = tension x courant). L'augmentation de la tension est l'option la plus viable1. Le secteur s'emploie donc actuellement à augmenter la tension. Pour cela, il faut modifier la conception de nombreux composants standard qui ont été élaborés au début de l'ère des ordinateurs et des serveurs, lorsque les densités de puissance étaient relativement faibles (2 à 3 kW par rack). Cela implique de nouvelles configurations pour les cordons d'alimentation, les unités de distribution d'énergie et les convertisseurs, car les niveaux de tension nécessaires dépassent les niveaux actuels (voir figure 3). Pour ce qui est des puces, les défis sont encore plus grands, car une tension plus élevée, et donc une alimentation électrique supérieure pour le GPU, nécessitent une refonte complète de l'alimentation électrique de la puce elle-même.

Figure 3 - Plus qu'un câble et une prise : la complexité des systèmes électriques des centres de données

Pour alimenter un centre de données en électricité, il faut de multiples systèmes interconnectés qui doivent fonctionner avec fluidité afin d'optimiser la performance de traitement. BT = dispositifs à basse tension, MT = dispositifs à moyenne tension

Source : Green Data Center Design and Management

Le refroidissement d'un centre de données est essentiel pour garantir des performances élevées et éviter les dysfonctionnements. Les solutions traditionnelles de CVC2 qui utilisent la climatisation et les ventilateurs pour refroidir l'air dans les salles des serveurs des centres de données sont suffisantes pour les CPU dont les racks de serveurs gèrent des densités de puissance comprises entre 3 et 30 kW, mais pas pour les GPU dont les densités de puissance dépassent facilement les 40 kW3. Étant donné que les racks de GPU les plus récents dépassent ces niveaux de puissance, il est beaucoup question (une fois de plus) de renforcer les systèmes de refroidissement liquide. Ces systèmes permettent une dissipation de la chaleur encore plus importante au niveau d'un rack de serveur ou d'une puce, car la capacité des liquides à capturer la chaleur par unité de volume est supérieure à celle de l'air. Mais ils s'accompagnent également de défis, notamment 1) le manque de modèles et de composants standardisés pour ces systèmes, 2) les différentes options technologiques telles que le refroidissement des puces ou des racks, et 3) les coûts élevés de la tuyauterie et des mesures visant à prévenir les fuites.

Nos perspectives sur la révolution de l'IA et son impact sur les besoins énergétiques des centres de données

La révolution de l'IA nécessitera rien moins que de repenser entièrement l'infrastructure interne et externe des centres de données afin de s'adapter aux besoins énergétiques beaucoup plus élevés des nouvelles technologies de l'IA. Il en résultera une forte augmentation de la demande et des investissements pour les centres de données sur les applications informatiques à faible consommation, les systèmes de CVC sobres et les solutions de gestion de l'énergie. Toutes ces solutions d'efficacité énergétique du Big Data sont des domaines d'investissement clés pour la stratégie Smart Energy.

La révolution de l'IA nécessitera rien moins que de repenser entièrement l'infrastructure interne et externe des centres de données

Les revenus des entreprises qui fournissent des solutions d'efficacité énergétique aux centres de données devraient connaître une forte croissance. Le marché a également bénéficié d'une forte revalorisation, comme en témoignent ces titres qui se négocient désormais dans la partie supérieure de leur fourchette historique en raison de perspectives de croissance beaucoup plus élevées. Compte tenu de la forte dynamique et des moteurs structurels sous-jacents, nous avons la plus grande confiance dans cette partie de l'univers d'investissement de l'énergie intelligente. Nous pensons également que ce secteur peut se mettre à l'abri d'une éventuelle récession, car les dépenses consacrées aux centres de données indispensables et aux solutions d'efficacité énergétique y afférentes ne dépendront pas du cycle économique.

Notes de bas de page

1 L'augmentation du courant nécessite des câbles plus épais, ce qui consomme davantage d'espace. Or, ce n'est pas une option viable étant donné l'étroitesse des racks de serveurs des centres de données d'aujourd'hui.

2 Chauffage, ventilation et climatisation.

3 Selon Schneider Electric, les niveaux de densité de puissance des racks de serveurs GPU sont en moyenne de 44 kW.