Fantastic 4: Vier Strategien für ein anspruchsvolles Marktumfeld

Melden Sie sich an, um Chancen im aktuellen Marktumfeld zu entdecken.

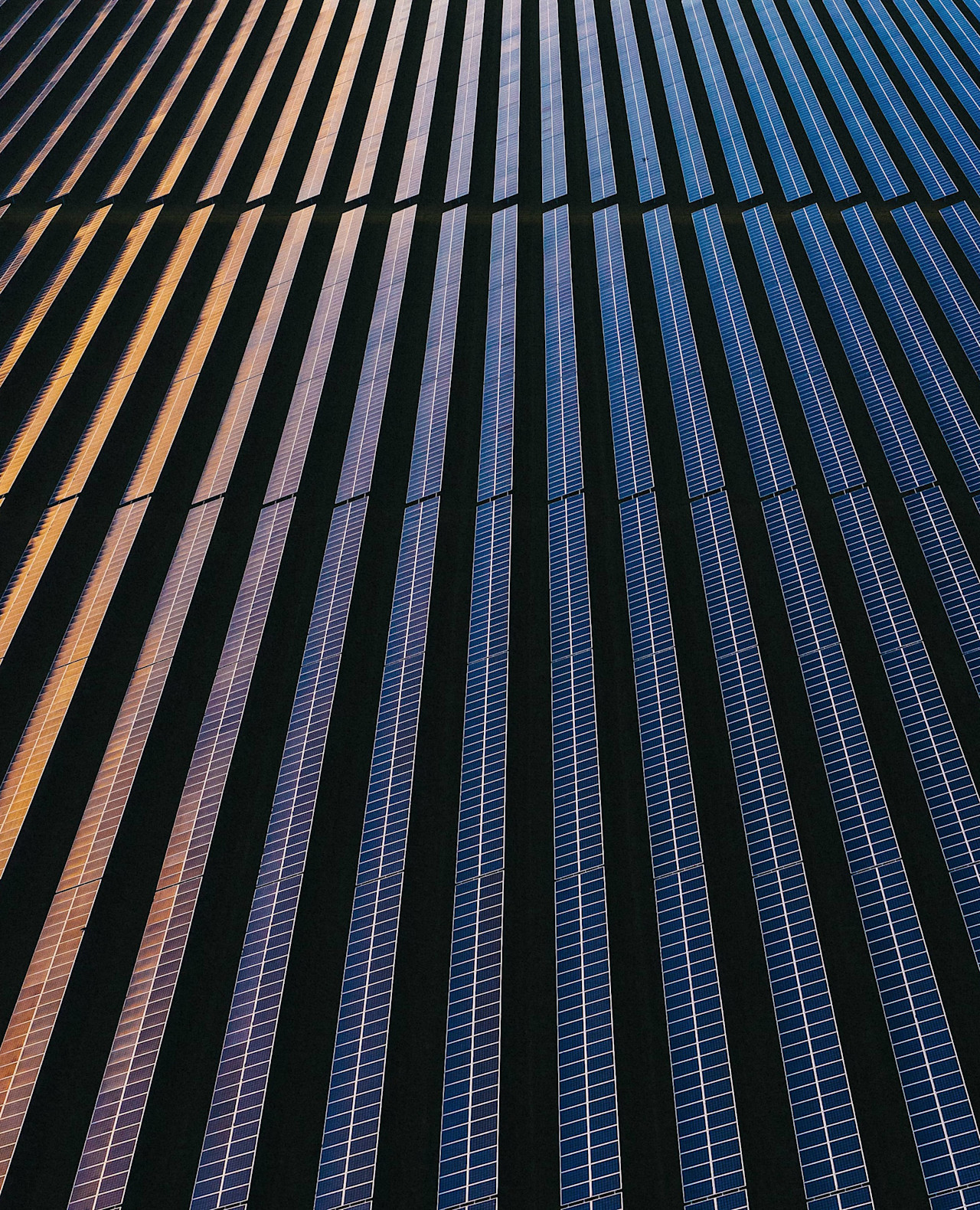

Als globaler Assetmanager orientieren wir unsere Anlagelösungen an Ihrem Bedarf. Wir sind getrieben von endloser Neugier, strikter Research-Orientierung und Leidenschaft für Nachhaltigkeit. Wir zeigen Ihnen den Weg zu bahnbrechenden aktiven Anlagestrategien.

Wollen Sie für den Bedarf von heute und den der Zukunft investieren? Unser gemeinsames Ziel ist, dass unsere Anlagen einen Beitrag zu einem intakten Planeten und einer gesunden Gesellschaft leisten. Nehmen Sie an der Diskussion teil und sprechen mit einem unserer Kollegen.

Melden Sie sich an, um Chancen im aktuellen Marktumfeld zu entdecken.

Wir freuen uns, Ihnen ein paar Chancen vorzustellen, die von unseren Experten ausgewählt wurden.

Systematischer und nachhaltiger Faktoransatz als Alternative zu passiven Anlagen

Konzentrierte und uneingeschränkte Investitionen in die hellsten Sterne Asiens

Ausrichtung auf stetige Erträge durch Anlage in Unternehmen, die zu den SDGs beitragen

Eine neuartige Anlagelösung, die das Staatsanleihenportfolio mit Klimaschutzmaßnahmen in Einklang bringt

Warnung – Betrügerischer Verweis auf Robeco von Websites und in sozialen Medien Mehr lesen